发布日期: 2025年12月31日

版本号: V5.2.0

更新概述:

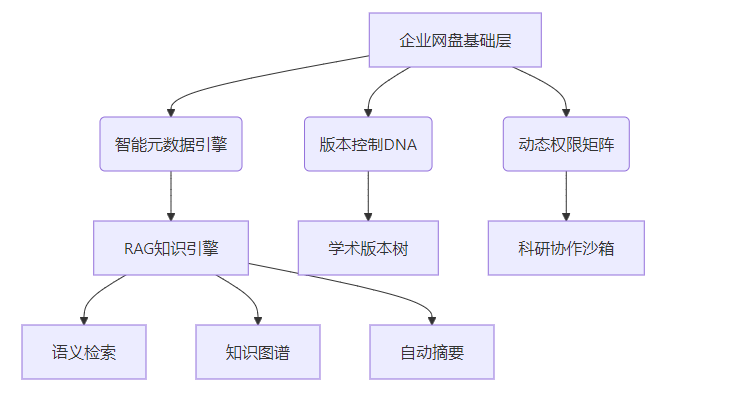

本次一粒云V5.2.0版本更新是一次深度的功能迭代与体验升级。我们重点加强了底层权限体系的灵活性,完善了多源组织架构的同步能力,并深化了RAG深度搜索与企业微信的生态融合。同时,针对隔离网传输安全(摆渡)、ISO体系文控以及云笔记模块进行了专项优化,旨在为企业提供更安全、更智能、更高效的文档云协同平台。

一、 协同网盘

协同网盘模块在本次更新中着重优化了分享体验、通知机制以及文件管理的精细化程度。

1. 外链与分享增强

- 外链安全升级: 新增外链密码自动更新功能,支持设置密码更新频率,并在密码更新时自动发送通知到企业微信,确保分享链路的安全性。

- RAG深度融合: 完成外链增加与取消操作向RAG服务接口的推送,实现分享文件的深度索引。

- 分享行为审计: 完善分享文件的更新记录功能,当分享文件发生变动时,系统会自动记录并向企业微信推送消息通知。

- 搜索与索引: 新增分享文件的搜索功能,支持对分享文件进行全文检索标识的管理,提升分享内容的检索效率。

- 逻辑优化: 优化了分享索引队列缓存,解决了分享文件列表排序无效、旧数据文件名不匹配等问题;修复了共享控件权限及预览下载权限的判定逻辑。

2. 文件生命周期管理

- 文件到期属性: 新增文件到期属性设置功能,支持设置文件的失效时间。系统将自动检测文件过期状态,并在文件即将到期或已过期时,通过企业微信消息通知相关人员。

- 文件操作优化: 修复了不允许修改文件名后缀时重命名文件夹失败的问题;修复了文件夹删除后访问外链的提示逻辑;优化了文件列表的数字排序规则。

3. 用户体验与界面

- “我的转存”功能: 将原有的“收藏分享文件”交互升级为“我的转存”,操作更符合用户直觉。

- 内部分享通知: 内部分享操作增加企业微信消息通知,并在消息中附带“我收到的”跳转地址,方便用户快速定位。

文件列表性能:

为满足大规模数据导出需求,将 /apps/files 接口默认返回条目数上限由 200 调整为 1,000,000。

二、 隔离网传输安全(收发信与内容鉴定)

针对高安全级别的隔离环境,本版本强化了摆渡信件的逻辑处理、传输链路检查及审计能力。

1. 信件收发逻辑优化

- 逻辑删除: 新增信件逻辑删除功能,解决了信件收发人同时删除导致的数据一致性问题,保障数据可追溯性。

- 链路检查机制: 增加发信前的链路检查功能。若链路不存在,信件将无法发送;同时,在流程审批环节触发链路检查,确保审批通过后传输通道的可用性。

- 移动端支持: 解决了手机端下载摆渡文件令牌无效的问题;针对iOS企业微信环境,文件下载逻辑由预览调整为Zip打包下载,确保文件完整获取。

2. 审计与监控

- 审计日志完善: 摆渡审计列表增加发起人部门ID和网络ID的筛选维度;导出报表中新增信件状态字段及申请人部门字段,满足合规审计需求。

- 状态监控: 服务重启时自动移除文件移动锁,防止死锁导致传输失败;增加摆渡信件禁用开关,提供灵活的管控手段。

3. 审批流程修复

* 修复了文档审批中上传、更新、删除无法操作或检查报错的问题,确保隔离网间文件审批流程的顺畅。

三、 第三方扩展与组织架构

本版本大幅提升了系统的集成能力,实现了多源组织架构的统一管理与第三方系统的无缝对接。

1. 多源组织架构与用户同步

- 多源架构支持: 部门表拆分为部门表与绑定表,完美兼容多源组织架构。支持同时从金蝶云、布谷智慧校园、AD域、用友、云之家等不同来源同步组织架构。

- 同步机制优化: 实现了部门同步和用户同步的基类与缓存机制;AD域同步采用fork形式,大幅降低资源占用;修复了云之家删除部门同步失败等同步结果不准确的问题。

- 标准化管理: 支持手动触发同步及获取同步详情,补充组织架构同步错误信息的展示,优化用户所在部门的 fullName 展示字段。

2. 统一身份认证(SSO)

- 多协议支持: 支持CAS单点登录(支持URL参数、自定义字段)、Keycloak集成,并增加了一粒云ISO系统免登及用户云盘信息获取接口。

- 金蝶云集成: 新增金蝶云第三方服务配置列表接口及登录跳转接口,支持从配置中获取新用户的默认密码。

- 免密登录增强: 第三方免密登录支持修改Key,并将时间戳验证设为可选配置,增强了集成的灵活性。

3. 企业微信生态

* 深度优化了企业微信登录、文件下载、消息推送等场景,修复了iOS下载变预览、工作台登录失败、同步失败(表名错误)及消息通知范围不准等多个核心问题。

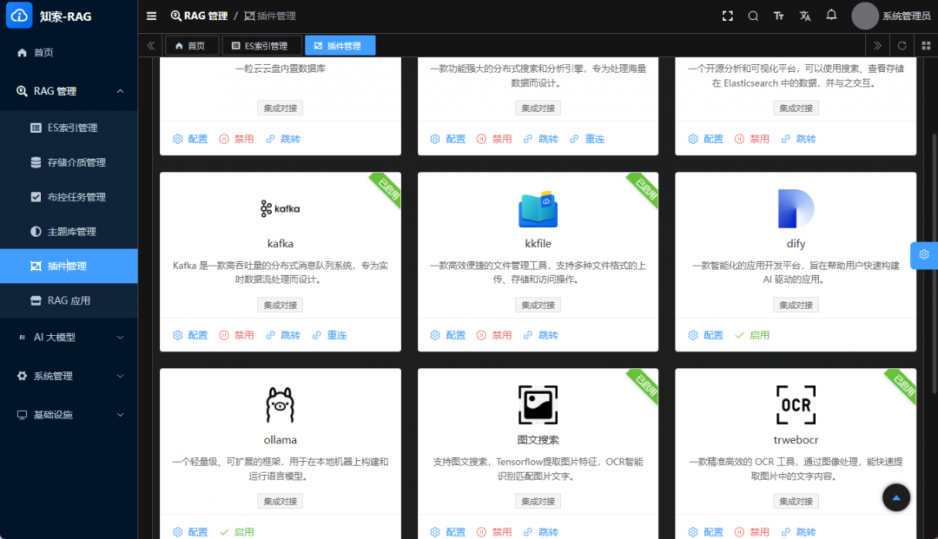

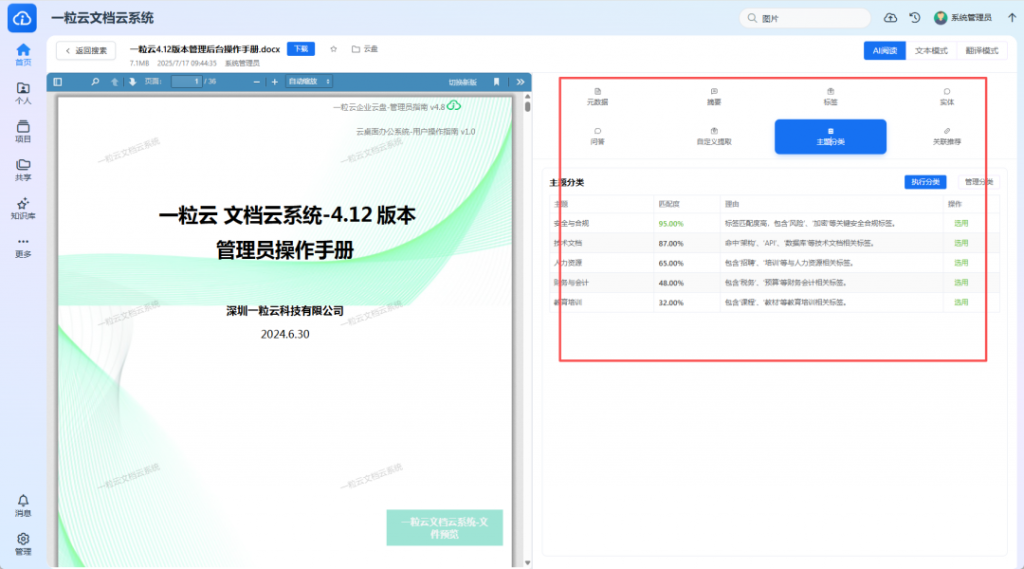

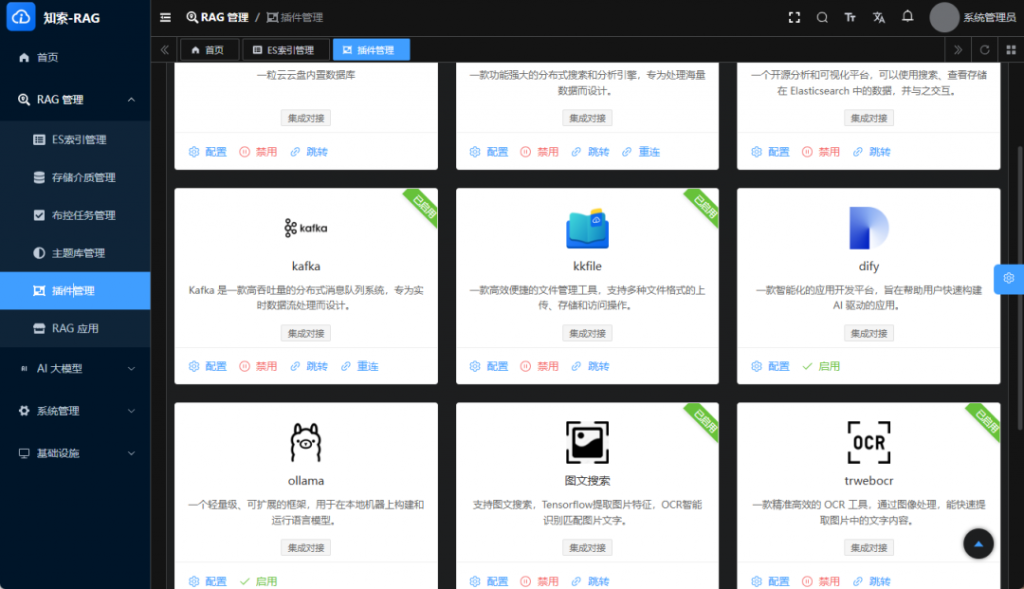

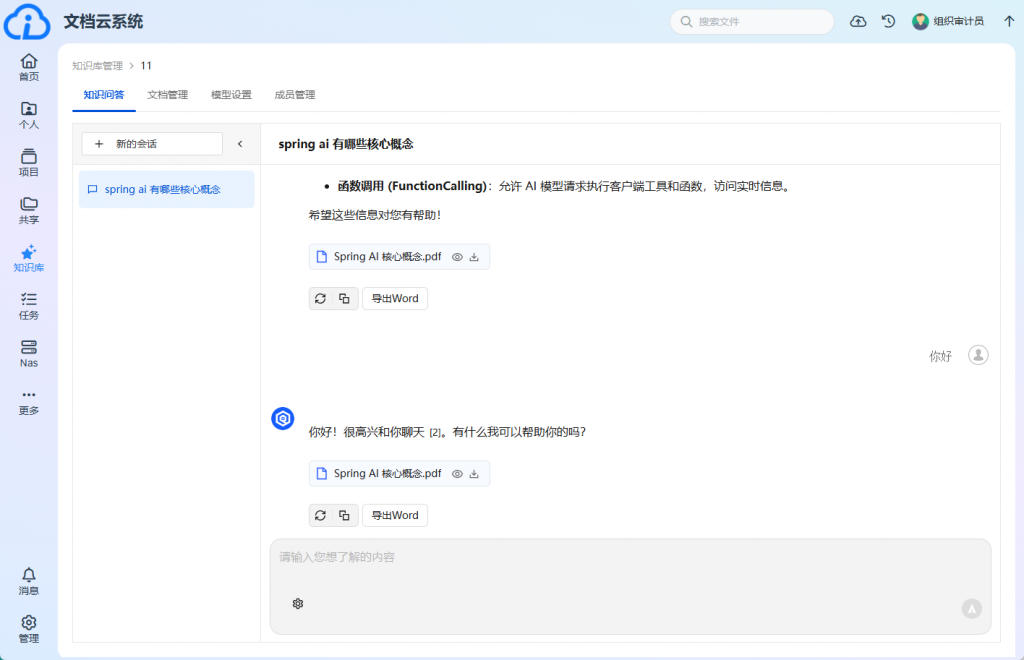

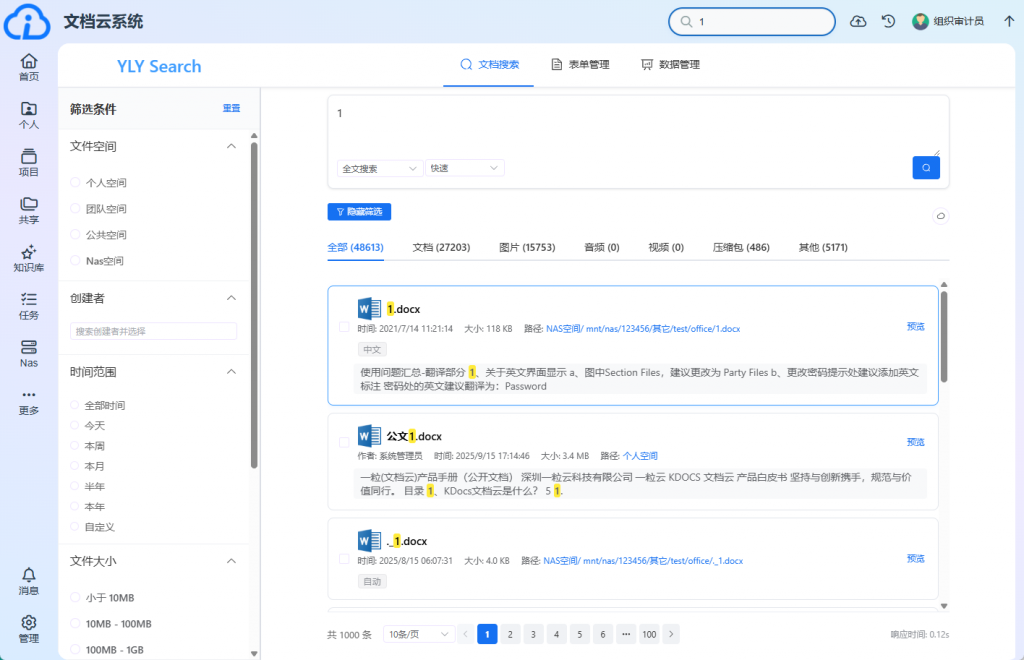

四、 RAG深度搜索

RAG模块在本次更新中扩展了数据源接口,并优化了索引的实时性。

- 外链数据接入: 完成外链增加与取消发送至RAG服务的接口开发,使外链分享的文件也能被RAG系统实时抓取和分析。

- 索引管理: 增加了分享文件全文检索标识的添加与删除功能;索引状态加上了变更文件路径的情况,确保搜索结果的准确性。

* 搜索优化: 修复了关键词为空或无选中标签时全盘搜索失效的Bug;优化了文件搜索的权限过滤逻辑,解决了个人权限与部门权限合并不准确、Limit太小导致搜索遗漏的问题。

五、 文控模块(体系文件管理、体系文件审批)

针对ISO文控需求,本次更新重点加强了文档的安全属性和审批流程的稳定性。

- 水印管理: 完成文件属性指定水印内容功能,系统优先使用文件属性中定义的水印内容。外链预览水印新增分享创建人名称和IP地址,提升溯源能力。

- 文档审批: 修复了文档审批流程中上传、更新、删除操作报错的问题,确保体系文件审批流程的闭环。

* 文控安全: 增加了远程路径挂载情况的判断逻辑;修复了共享空间文件列表权限判定、父/子文件夹授权优先级等权限逻辑问题。

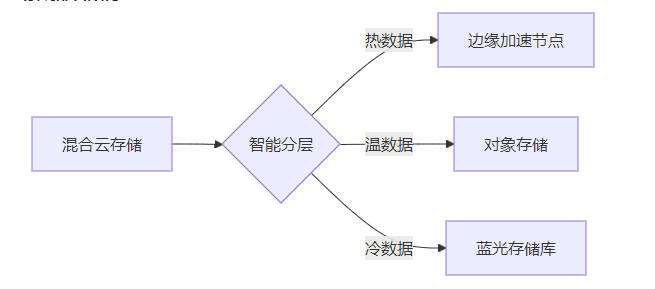

六、 底层安全(分布式存储、加密、传输)

底层安全模块在权限控制、存储性能及加密传输方面进行了全面加固。

1. 权限体系重构

- 角色权限系统: 增加角色权限判定和角色授权功能,支持角色成员日志记录。优化了权限继承逻辑,解决了父文件夹授权角色可见后,子文件夹授权失效;以及管理后台“看权限”列表中子部门用户不显示权限记录等复杂场景下的Bug。

- 空间权限: 修复了部门空间对角色授权无效、指定共享空间授权未忽略系统管理员等问题。

2. 存储与传输优化

- 下载机制: FDFS文件下载由HTTP下载改为命令行下载,去掉了对云盘文件是否存在的多余判断,修复了去掉杀毒节点导致发送失败的问题,提升了传输效率。

- 缓存策略: 检查部门空间使用24小时缓存机制,缓存对应部门ID的已使用空间,减少数据库压力。

- 并发与资源: 调整请求体解析器大小限制,避免同步大量部门时触发PayloadTooLargeError;取消多任务打包,防止资源不足导致打包失败;调整build编译内存配置。

3. 系统级修复

* 去掉了OA登录到云盘的信任IP地址限制;修复了1024长度字段无法创建索引、5.1.0.sql字符编码字段过长等问题。

七、 云笔记模块

云笔记模块在安全性和协作性上进行了功能补全。

- 外链分享完善: 云笔记外链分享新增访问密码和过期时间设置,提升分享安全性。

* 权限控制: 新增云笔记分享的可编辑权限设置,修复了编辑分享笔记的Bug,满足了多人协作场景下的精细化权限需求。

总结:

一粒云V5.2.0版本通过整合多源架构、深化RAG应用、强化企业微信集成以及重构底层权限逻辑,全面提升了企业文档管理的安全性与协作效率。本次更新不仅修复了大量已知问题,更在用户体验、系统性能及高阶安全功能上实现了质的飞跃,为2025年的文档云服务画上了完美的句号。