一、「邮件分析」在军事领域中的定位

在军事/安全体系中,邮件并不只是“通信内容”,而是被视为一种:

结构化证据载体(Evidence Artifact)

它通常用于支持以下判断之一:

- 是否存在 组织关系

- 是否存在 指挥 / 协调 / 情报传递

- 是否存在 意图、计划或准备行为

- 是否存在 异常通信或敌对行为迹象

因此分析目标不是“读懂邮件”,而是:

证明:谁,在什么时间,以什么方式,与谁,传递了什么意图或信息,其可信度有多高。

二、军事邮件分析的「证据要素体系」(核心)

可以理解为 5 大证据层 + 1 个综合判断层。

一)通信元数据证据(Metadata Evidence)

这是最基础、但法律与军事上权重极高的一层

典型要素

- 发件人 / 收件人(To / CC / BCC)

- 邮件地址特征

- 发送时间(含时区)

- 邮件服务器路径(路由痕迹)

- 邮件频率与节奏

可得结论类型

- 是否为固定通信关系

- 是否存在指挥链 / 汇报链

- 是否出现:

- 突然高频

- 异常时间段(深夜、行动前)

👉 这一层不依赖内容,哪怕邮件是空的也有价值

二)身份与角色证据(Identity & Role Evidence)

目标:判断“这是谁,不只是他用了哪个邮箱”

分析维度

- 邮箱命名规则

- 签名档风格

- 职称、部门、用语习惯

- 多封邮件中的一致性

结构化结果示例

{

"推断身份": "作战协调人员",

"依据": [

"多次使用任务调度语言",

"邮件常位于抄送链中上游",

"署名与其他渠道一致"

],

"置信度": 0.82

}

三)内容语义证据(Semantic & Intent Evidence)

⚠️ 这是 LLM 发挥最大作用的一层,但军事系统中不会单独使用

抽取内容

- 明确指令(命令式语言)

- 协调行为(时间、资源、人员)

- 暗示性意图(准备、试探、评估)

- 任务阶段词汇(如:准备 / 执行 / 汇总)

关键点

- 不是“关键词命中”

- 而是:

- 行为意图

- 语气强度

- 指令明确度

四)上下文与跨邮件链证据(Contextual Evidence)

单封邮件价值有限,真正的证据来自“邮件序列”

分析内容

- 话题演进

- 任务推进阶段

- 决策是否在某一封邮件后发生变化

示例判断

- 某邮件 → 行动开始前 T-48 小时

- 后续邮件 → 确认 / 执行 / 回报

👉 这是“计划存在性”的核心证据来源

五)异常与对抗痕迹证据(Anomaly & Deception Evidence)

军事情报中特有的一层

可疑信号

- 用词突然变化

- 常用渠道中断,改用私人邮箱

- 邮件极简但频率增加

- 明显“避实就虚”的表述

不是定罪,而是标记

{

"异常类型": "通信模式突变",

"表现": "频率上升但内容显著减少",

"潜在解释": ["行动前保密", "渠道被监控"]

}

三、最终呈现的「分析结果形态」

军事领域不会输出“结论性一句话”,而是多层结果。

1️⃣ 证据结构化摘要(Evidence Summary)

- 邮件编号

- 涉及人员

- 涉及事件

- 证据类型

- 可信度评分

2️⃣ 通信关系图(Network Graph)

- 人 ↔ 人

- 邮件频次、方向

- 核心节点识别

👉 常用于指挥链 / 组织结构推断

3️⃣ 时间线(Timeline)

12-01 初次协调

12-03 资源确认

12-05 行动窗口确认

12-07 异常通信

4️⃣ 分析性判断(Analyst Judgment)

⚠️ 由系统辅助,人类分析员完成

典型格式:

“基于邮件通信元数据、语义内容及上下文序列,

高度可能存在一个持续的协调行为,其目的与某项行动准备阶段一致。

该判断的置信度为中高。”

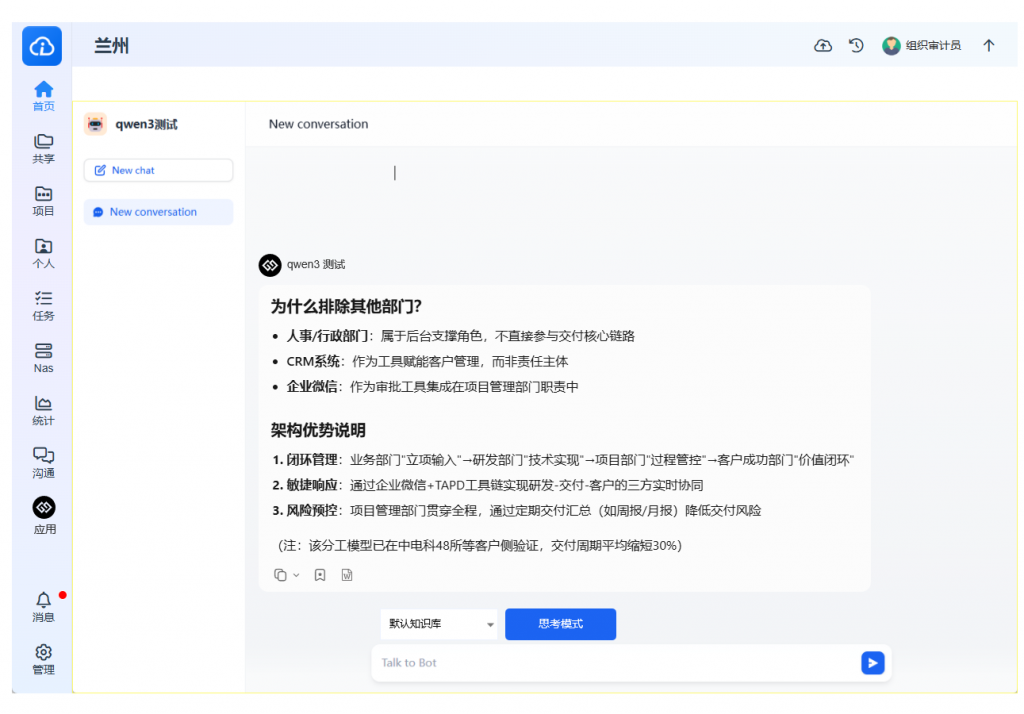

四、LLM 在其中的“边界角色”

在军事领域,LLM 不会:

- 独立做最终判断

- 自动生成“行动结论”

它 只做三件事:

- 结构化证据

- 提供解释性线索

- 标记不确定性

五、你如果站在「系统设计者」视角,可以这样定义邮件分析模块

邮件 = 通信证据对象(Communication Evidence Object)

包含:

- 原始内容(只读)

- 抽取字段

- 推断标签

- 证据来源

- 置信度

- 人工复核记录

最后一句总结(很重要)

军事邮件分析的核心不是“发现秘密”,

而是“把零散通信,变成可被质询、可被反驳、可被复核的证据链”。

如果你愿意,下一步我可以继续帮你:

- 设计一套 “邮件证据结构化 JSON Schema”

- 或对比 情报邮件分析 vs 企业合规/内控邮件分析

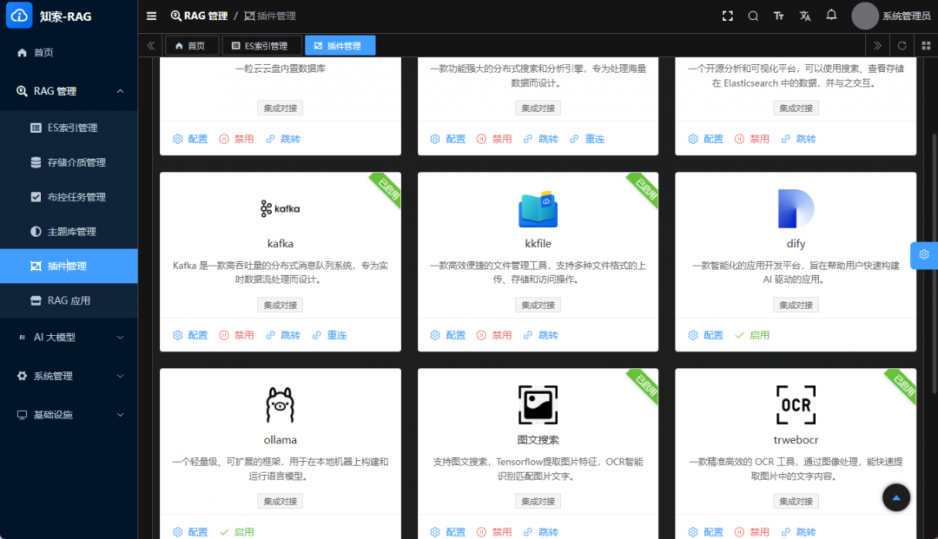

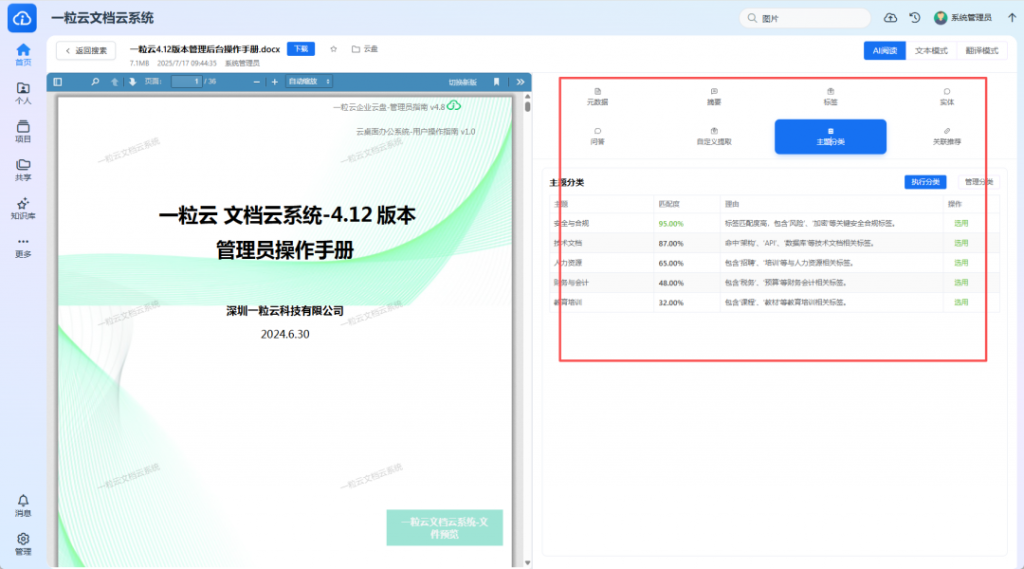

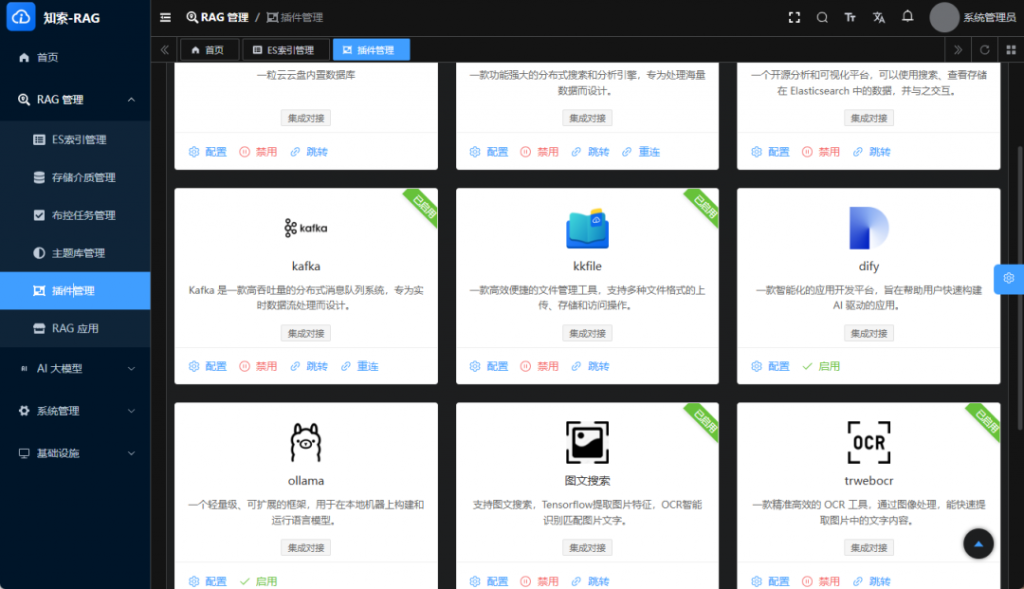

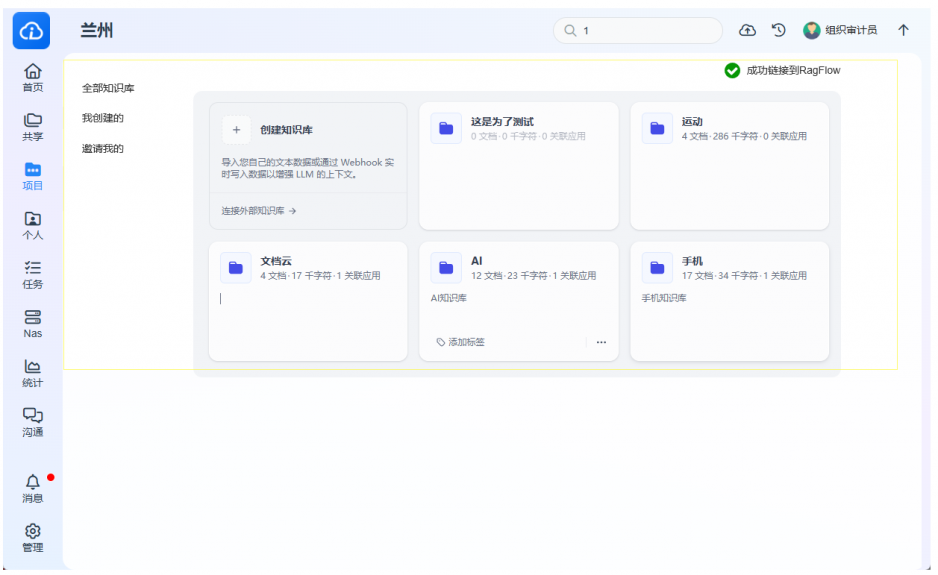

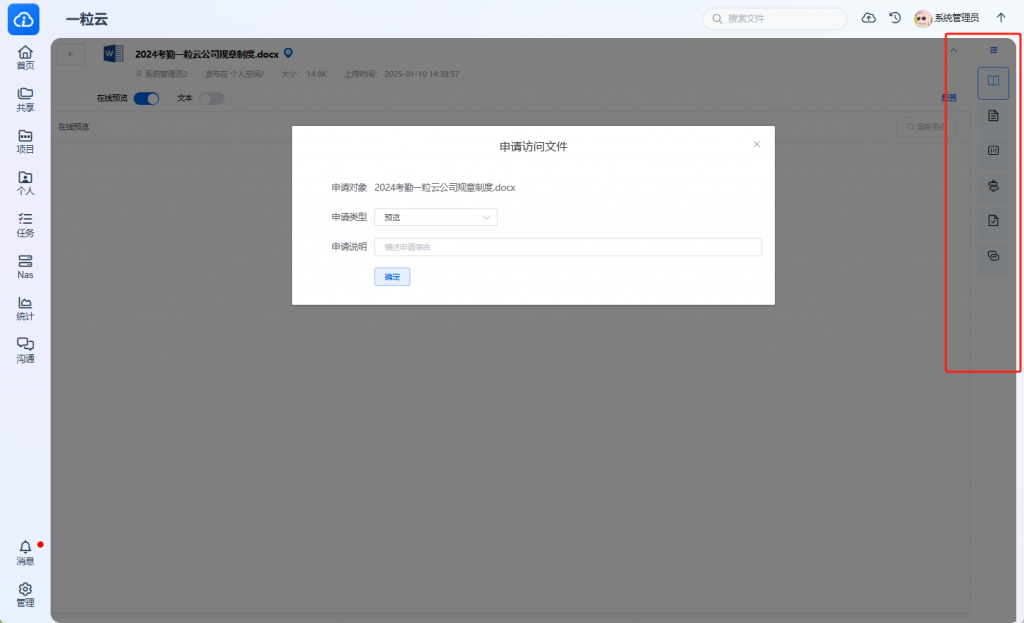

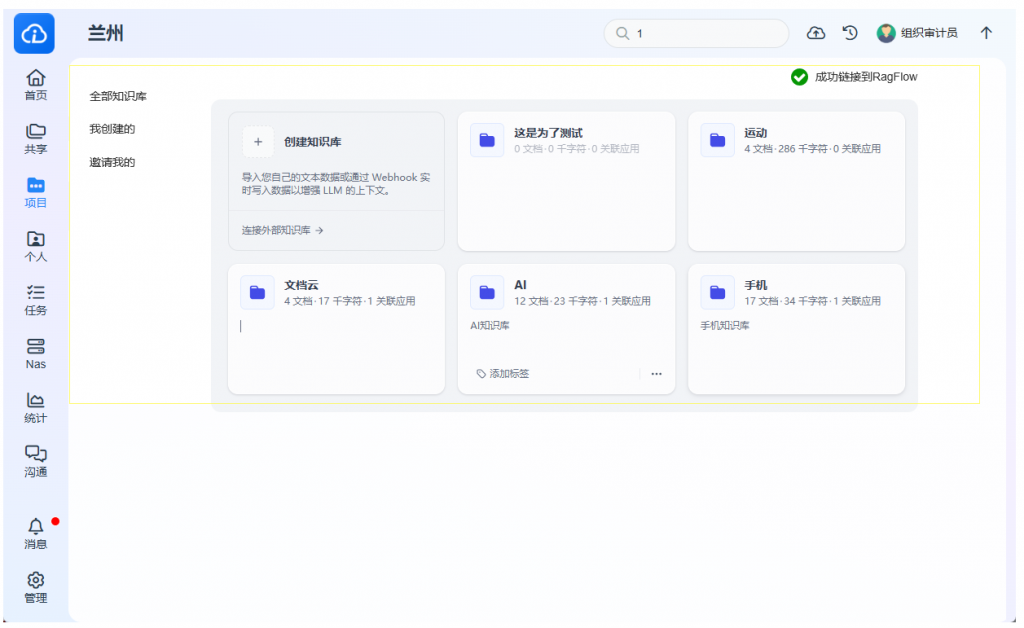

- 或从你做的 文档云 / RAG / 离线模型角度,给一套安全可控的技术架构

你更想往系统设计还是分析方法论继续深入?